Dernière mise à jour : 22 février 2026 | Temps de lecture : 15 min

Qu’est ce que le context engineering?

Imaginez que vous demandiez à un avocat de défendre votre dossier, mais que vous ne lui donniez qu’une page de résumé.

Il ferait de son mieux, mais le résultat serait médiocre.

Maintenant, imaginez que vous lui fournissiez : le dossier complet, l’historique des précédents, les documents de l’adversaire, et des outils pour rechercher la jurisprudence en temps réel. Le résultat serait radicalement différent.

C’est exactement la différence entre le prompt engineering et le context engineering.

Vous avez peut-être remarqué que vos agents IA échouent 30% du temps, non pas parce que le modèle est mauvais, mais parce qu’il ne dispose pas des bonnes informations au bon moment. Les hallucinations, les réponses incohérentes, les échecs de tâches complexes : dans 80% des cas, ce sont des échecs de contexte, pas des échecs de modèle. Et voilà le paradoxe : pendant qu’on s’est tous concentrés sur l’art du prompt parfait, les vrais professionnels de l’IA étaient déjà passés à autre chose.

Comme le dit Andrej Karpathy, ex-responsable IA chez Tesla et OpenAI : « Le context engineering est l’art délicat et la science de remplir la fenêtre de contexte avec exactement les bonnes informations pour l’étape suivante. »

Andrej Karpathy

Ce guide est différent. C’est le premier guide francophone complet qui vous permet de :

- Comprendre pourquoi le context engineering remplace le prompt engineering (5 min de lecture)

- Architecturer vos systèmes d’agents avec les bons composants de contexte (10 min)

Qu’est-ce que le context engineering ? (définition et fondamentaux)

Vous pensez maîtriser le prompt engineering ? Et si je vous disais que ce n’est que la partie émergée de l’iceberg ? Plongeons dans ce qui se cache en dessous : l’ingénierie de contexte.

Du prompt engineering au context engineering : une évolution naturelle

Le prompt engineering, c’est l’art de formuler une question précise pour obtenir la meilleure réponse possible d’un LLM. C’est efficace, mais terriblement limité. Dès que la tâche se complexifie, que l’agent doit se souvenir d’échanges passés ou utiliser des outils, le simple prompt ne suffit plus.

La révélation est là : ce n’est pas le prompt qui compte, c’est tout ce qui l’entoure.

Le modèle ne réagit pas à une simple instruction, mais à un ensemble d’informations que nous lui fournissons. C’est cet ensemble que l’on nomme le « contexte ». L’ingénierie de contexte est donc la discipline qui consiste à construire et gérer ce contexte de manière stratégique.

💡 En pratique :

Un chatbot simple qui répond à des questions factuelles → le prompt engineering suffit. Un agent qui doit analyser vos emails, consulter votre agenda, et rédiger une réponse personnalisée en fonction de votre style → le context engineering est indispensable.

Définition : le context engineering en une phrase

Si l’on devait le résumer, voici une définition inspirée des travaux d’Anthropic et LangChain :

Le context engineering est la discipline qui consiste à concevoir, construire et optimiser dynamiquement l’ensemble des informations (instructions, données, historique, outils) présentées à un LLM dans sa fenêtre de contexte pour maximiser sa performance sur une tâche donnée.

Chaque mot est important :

- concevoir (l’architecture),

- construire (l’implémentation),

- optimiser dynamiquement (ce n’est pas statique)

- maximiser la performance (l’objectif final).

On passe d’un artisanat (le prompt) à une véritable ingénierie de systèmes.

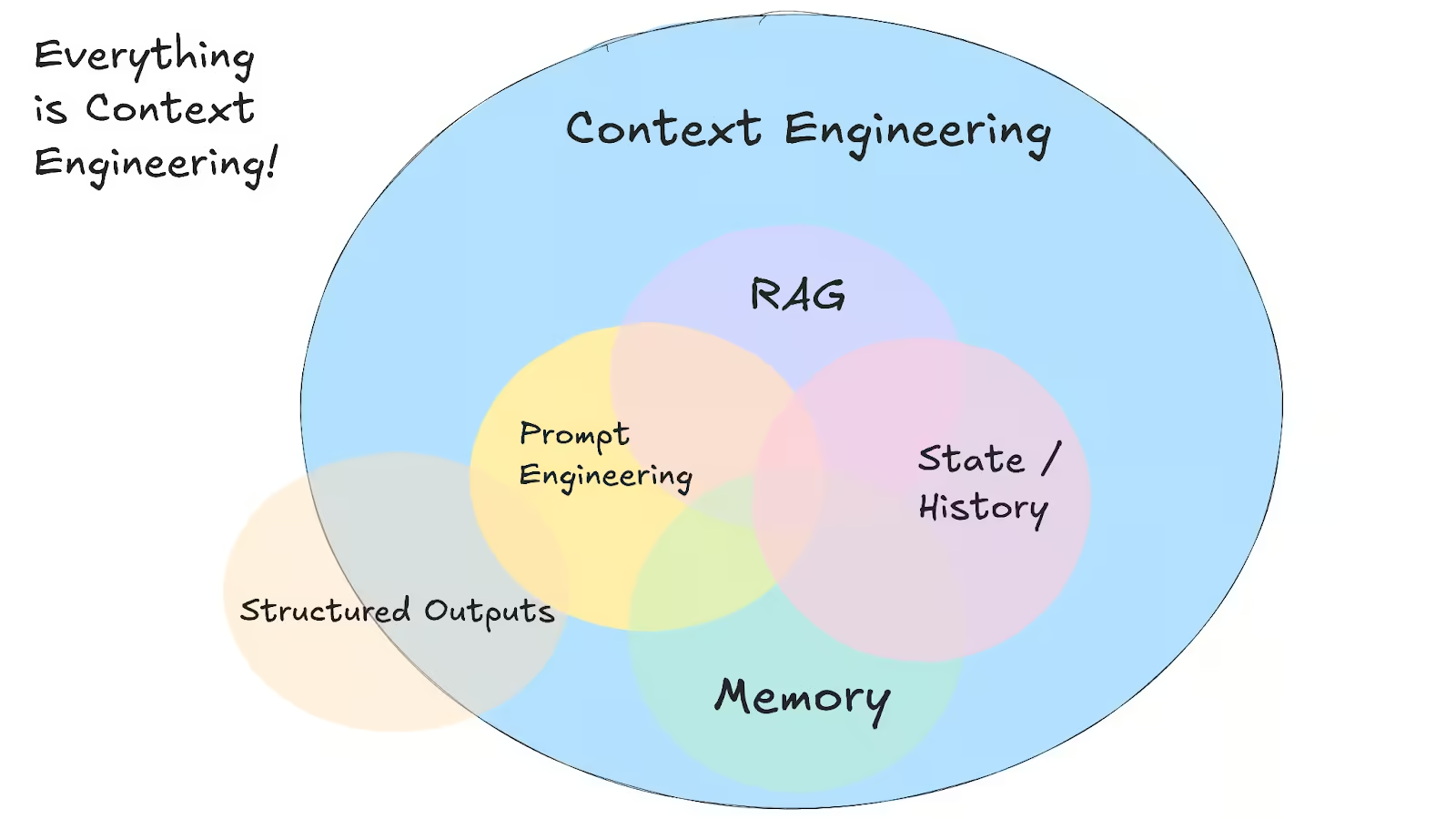

Les composants du contexte : anatomie complète

La fenêtre de contexte (ou context window) d’un LLM est sa mémoire de travail. Tout ce que vous y placez influence sa réponse. L’ingénierie de contexte consiste à assembler méticuleusement les bons ingrédients.

Voici les 7 composants essentiels :

- Instructions système (System Prompt) : La « constitution » de l’agent. Elle définit son rôle, sa personnalité, ses contraintes et ses objectifs généraux.

- Prompt utilisateur : La requête immédiate de l’utilisateur. C’est le déclencheur de l’action.

- Mémoire court terme : L’historique récent de la conversation pour maintenir la cohérence d’un échange.

- Mémoire long terme : Les informations persistantes sur l’utilisateur, ses préférences, ou des faits importants appris lors d’interactions passées.

- Connaissances externes (RAG) : Des documents, données ou informations extraits en temps réel d’une base de connaissances pour répondre à la question (Retrieval-Augmented Generation).

- Outils disponibles : La description des fonctions ou API que l’agent peut appeler (ex: « rechercher sur internet », « envoyer un email »).

- Format de sortie structuré : Des instructions précises sur la manière de formater la réponse (ex: JSON, XML) pour qu’elle soit utilisable par un autre système.

Infographie exclusive : L’Anatomie d’un Contexte LLM Optimal. Chaque composant joue un rôle critique dans la performance de l’agent.

Pourquoi le context engineering change tout (impact business & technique)

Vous vous demandez peut-être si cet effort supplémentaire en vaut vraiment la peine. La réponse est un oui retentissant. Ignorer l’ingénierie de contexte, c’est comme piloter une Formule 1 avec du carburant de tondeuse : vous n’utilisez qu’une fraction du potentiel et vous risquez la panne à chaque virage.

Les échecs d’agents sont des échecs de contexte (pas de modèle)

Une statistique issue des retours d’expérience de la communauté LangChain est éclairante : 70 à 80% des échecs d’agents en production proviennent d’un contexte incomplet ou mal structuré. Ce n’est pas le LLM qui est « stupide », c’est le contexte que vous lui avez fourni qui l’a induit en erreur.

Voici des exemples concrets d’échecs typiques :

- Manque d’information : L’agent « hallucine » une réponse car il n’a pas accès au bon document via le RAG.

- Contexte trop long : La fenêtre de contexte est saturée, et l’agent « oublie » les instructions initiales du system prompt.

- Format mal structuré : L’agent ne parvient pas à appeler un outil car la description de celui-ci est ambiguë.

⚠️ Erreur courante :

Augmenter la taille du modèle (passer de GPT-4 à GPT-5.2) ou changer de fournisseur (d’OpenAI à Anthropic) en pensant résoudre les problèmes de fiabilité. C’est souvent une dépense inutile si le véritable goulot d’étranglement est le context engineering.

Le ROI du context engineering : chiffres concrets

Un bon context engineering n’améliore pas seulement la qualité. Il a un impact direct et mesurable sur vos coûts et vos performances.

- Réduction des coûts d’API : En optimisant ce que vous envoyez au modèle et en utilisant des techniques de cache (comme le KV-caching), vous pouvez réduire vos factures d’API jusqu’à 90%.

- Amélioration du taux de succès : Des études de cas rapportent une augmentation de 30 à 50% du taux de complétion de tâches complexes par les agents IA.

- Réduction de la latence : Un contexte bien géré et mis en cache peut réduire le temps de première réponse (TTFT) d’un facteur 10.

🎯 Impact business :

Imaginez un agent de support client. Une meilleure ingénierie de contexte signifie moins d’escalades vers des humains (-25% de coûts), des réponses plus rapides (+40% de satisfaction client) et une capacité à gérer des problèmes plus complexes (automatisation de 80% des requêtes au lieu de 50%).

Cas d’usage : quand le context engineering devient indispensable

Le prompt engineering seul peut suffire pour des démos.

Pour des applications en production, l’ingénierie de contexte est non négociable.

Voici 5 scénarios où elle fait toute la différence :

- Agents conversationnels avec mémoire : Pour qu’un chatbot se souvienne de vous et de vos préférences d’une conversation à l’autre.

- Assistants de code (type GitHub Copilot) : Pour que l’assistant comprenne l’ensemble de votre projet (fichiers ouverts, dépendances) et pas seulement le fichier actif.

- Agents de recherche et analyse : Pour synthétiser des informations provenant de multiples documents, pages web et bases de données.

- Automatisation de workflows métier : Pour un agent qui doit interagir avec plusieurs systèmes (CRM, ERP, messagerie) pour accomplir une tâche en plusieurs étapes.

- Applications RAG avancées : Quand une simple recherche vectorielle ne suffit pas et qu’il faut des stratégies de re-ranking, de fusion de résultats et de résumé.

Architecture du context engineering : les patterns qui marchent

Comment passer de la théorie à une architecture robuste ? Il ne s’agit pas de tout jeter dans la fenêtre de contexte en espérant que ça marche. Il existe des stratégies et des patterns éprouvés pour structurer le flux d’informations.

Les 4 stratégies de gestion du contexte

Inspiré par un article fondateur d’Anthropic, on peut décomposer la gestion du contexte en quatre stratégies complémentaires :

- Write (Écrire) : C’est l’étape de construction initiale du contexte. On y assemble le system prompt, la requête de l’utilisateur et les informations statiques.

- Select (Sélectionner) : Avant d’ajouter des informations dynamiques (comme des documents via RAG ou l’historique de conversation), on sélectionne uniquement les plus pertinentes pour la tâche en cours.

- Compress (Compresser) : Quand la fenêtre de contexte est pleine, on utilise des techniques pour résumer les informations moins importantes (ex: résumer les premiers échanges d’une longue conversation).

- Isolate (Isoler) : Pour les tâches complexes, on peut créer des sous-contextes dédiés à des sous-tâches spécifiques, pour éviter que l’agent ne soit confus.

Le pattern RAG : enrichir le contexte dynamiquement

Le RAG (Retrieval-Augmented Generation) n’est pas un concurrent du context engineering, c’est l’un de ses piliers. C’est la stratégie de « Select » la plus courante. Son rôle est de trouver et d’injecter la bonne connaissance externe au bon moment.

L’architecture classique est bien connue : la requête est transformée en vecteur (embedding), utilisée pour chercher des documents similaires dans une base de données vectorielle, et les documents trouvés sont ajoutés au contexte.

Mais les bonnes pratiques de 2026 vont plus loin :

- Chunking intelligent : Découper les documents en blocs qui ont un sens sémantique, pas seulement par nombre de mots.

- Métadonnées riches : Attacher des métadonnées (date, source, auteur) aux chunks pour permettre un filtrage post-recherche.

- Re-ranking : Utiliser un second modèle, plus petit et plus rapide, pour reclasser les documents trouvés par le retriever avant de les présenter au LLM principal.

Le RAG est une brique essentielle pour ancrer les agents IA dans la réalité de vos données.

Gestion de la mémoire : court terme vs long terme

Un agent sans mémoire est un agent amnésique, incapable de construire une relation ou de suivre une conversation complexe. La gestion de la mémoire est un aspect crucial de l’ingénierie de contexte.

- Mémoire court terme : C’est l’historique de la conversation en cours. La technique la plus simple est de garder les N derniers échanges. Une approche plus avancée est la « summarization », où l’agent résume périodiquement la conversation pour économiser des tokens.

- Mémoire long terme : Elle stocke des informations sur l’utilisateur entre les sessions. On peut utiliser des techniques simples (stockage clé-valeur) ou plus complexes comme la création d’un graphe de connaissances (knowledge graph) sur l’utilisateur.

État de l’art 2026 : innovations et tendances

Le domaine de l’ingénierie de contexte évolue à une vitesse fulgurante. Quelles sont les innovations de pointe qui définissent aujourd’hui la frontière de ce qui est possible ? Se tenir à jour est essentiel pour ne pas construire les systèmes de demain avec les outils d’hier.

ACE (Agentic Context Engineering) : les agents qui s’améliorent eux-mêmes

La recherche la plus excitante vient de Stanford : l’Agentic Context Engineering (ACE). L’idée est un changement de paradigme : au lieu qu’un humain optimise le contexte, l’agent apprend à l’optimiser lui-même.

Le concept : l’agent effectue une tâche, analyse son propre échec ou succès, puis réécrit ses propres instructions (son system prompt ou la description de ses outils) pour la prochaine tentative. C’est une boucle d’auto-amélioration qui se concentre sur le contexte, pas sur le fine-tuning du modèle. Les résultats publiés en octobre 2025 sont spectaculaires : +10.6% de performance sur le benchmark AppWorld et une réduction de 87% de la longueur du contexte, donc de la latence.

Source : Stanford ACE Paper, Octobre 2025

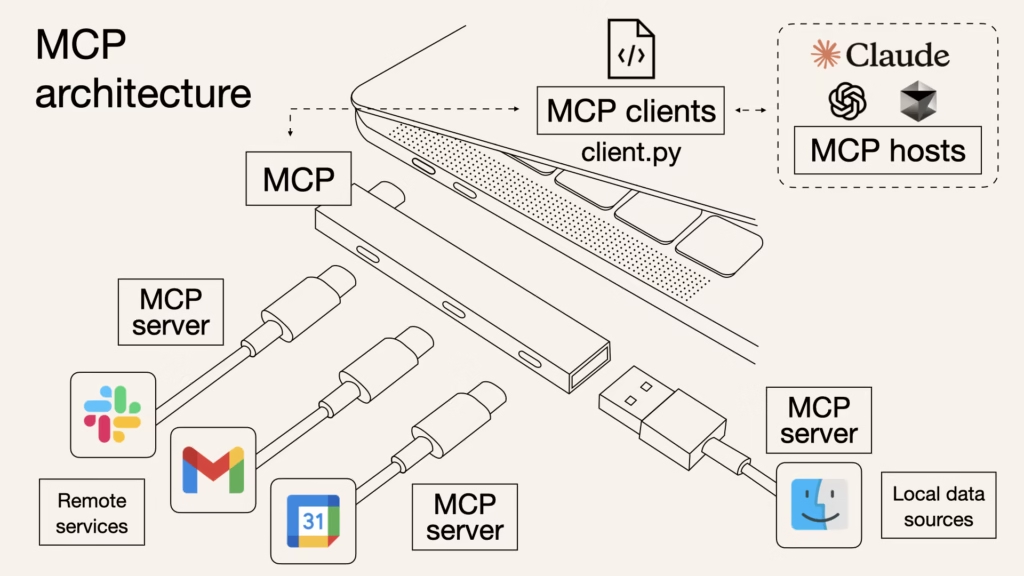

Model Context Protocol (MCP) : le standard universel

L’un des plus grands freins à l’adoption d’agents IA complexes était l’absence de standard pour connecter les agents à leurs outils et à leurs sources de données. Chaque API, chaque base de données nécessitait un connecteur sur-mesure. Le Model Context Protocol (MCP), initié par Anthropic, est en train de résoudre ce problème.

MCP est une spécification ouverte qui standardise la manière dont un agent peut découvrir et interagir avec des « serveurs de contexte » (outils, bases de données, API). C’est l’équivalent de l’HTTP pour le web, mais pour les agents IA. L’écosystème est en pleine explosion avec plus de 250 serveurs MCP publics disponibles, permettant à un agent de se connecter à des services comme Notion, Slack ou Google Drive avec une facilité déconcertante.

Les frontières de la recherche : context compression et meta-learning

La taille de la fenêtre de contexte reste une limite physique. La recherche se concentre sur des moyens de plus en plus intelligents de faire tenir plus d’informations dans le même espace. Des techniques de « compression sémantique » émergent, où un LLM est utilisé pour « compresser » un long document en un résumé dense en informations, qui est ensuite injecté dans le contexte de l’agent principal.

Une autre piste fascinante est le « meta-learning » appliqué au contexte. Des chercheurs entraînent des modèles non pas à résoudre une tâche, mais à apprendre comment construire le contexte optimal pour qu’un autre modèle résolve la tâche. C’est une mise en abîme qui promet des gains de performance significatifs pour les systèmes d’agents IA de demain.

Erreurs courantes et pièges à éviter

Vous êtes prêt à vous lancer, mais le chemin de l’ingénierie de contexte est semé d’embûches. Connaître les erreurs les plus fréquentes vous fera gagner des semaines de débogage et de frustration. Voici les 7 péchés capitaux à ne pas commettre.

Les 7 erreurs fatales en context engineering

Surcharger le contexte avec des informations non pertinentes.

⚠️ Piège : Penser que « plus il y a d’infos, mieux c’est ». Un contexte bruyant noie les instructions importantes et augmente les coûts. Solution : Soyez impitoyable. Utilisez des stratégies de « Select » et de « Re-ranking » pour ne garder que l’essentiel.

Ne pas valider la qualité des données récupérées (RAG).

⚠️ Piège : Faire une confiance aveugle à votre retriever. Si les documents qu’il remonte sont obsolètes ou incorrects, l’agent donnera une réponse fausse avec une grande confiance.

Solution : Mettez en place un pipeline de curation et de mise à jour de votre base de connaissances.

Oublier de gérer les limites de tokens.⚠️

Piège : Laisser une conversation s’allonger jusqu’à ce qu’elle dépasse la fenêtre de contexte, provoquant une erreur ou l’oubli des instructions initiales.

Solution : Implémentez une stratégie de « Compress » (ex: résumé de l’historique) bien avant d’atteindre la limite.

Ignorer l’ordre des informations dans le contexte.

⚠️ Piège : Placer les informations au hasard. Les LLMs sont sensibles à l’ordre : les informations au début et à la fin du contexte ont souvent plus de poids.

Solution : Placez les instructions critiques (system prompt) au début et les données les plus pertinentes (RAG) juste avant le prompt utilisateur à la fin.

Ne pas tester avec des contextes variés.

⚠️ Piège : Tester votre agent uniquement sur des cas nominaux. Solution : Créez des tests unitaires pour votre ingénierie de contexte : test avec un contexte vide, un contexte surchargé, des données de RAG contradictoires, etc.

Négliger la sécurité (prompt injection via le contexte).

⚠️ Piège : Penser que le prompt injection ne concerne que le prompt utilisateur. Un document malveillant dans votre base de RAG peut contenir des instructions cachées pour détourner votre agent.

Solution : Sanitizez toutes les données externes injectées dans le contexte et utilisez des séparateurs clairs entre les différentes parties du contexte.

Optimiser prématurément avant de mesurer.

⚠️ Piège : Passer des semaines à implémenter une stratégie de compression de contexte complexe sans savoir si la taille du contexte est réellement votre problème.

Solution : Instrumentez votre code. Mesurez la taille de vos contextes, votre taux de cache hit, votre latence. Optimisez ce qui a un impact réel.

Ressources et outils pour aller plus loin

Ce guide vous a donné les clés, mais le voyage ne fait que commencer. Pour maîtriser l’art et la science de l’ingénierie de contexte, la pratique et la veille continue sont indispensables. Voici une sélection de ressources pour vous accompagner.

Documentation officielle

Ce sont les sources de vérité. Quand vous avez un doute, c’est ici qu’il faut chercher.

- Anthropic Context Engineering Guide : Une excellente introduction aux concepts business.

- LangChain Documentation : La documentation complète pour implémenter les patterns décrits ici.

- Prompt Engineering Guide : Bien qu’axé sur le prompt, il contient des sections de plus en plus fournies sur le context engineering.

Communauté et veille

Pour rester à la pointe et échanger avec d’autres praticiens.

- Comptes Twitter/X à suivre : @karpathy, @tobi (CEO Shopify), @ankrgyl (chercheur IA).

- Serveurs Discord : Les serveurs officiels de LangChain et Anthropic sont des mines d’or d’entraide.

- Newsletters recommandées : [Insérer ici le nom d’une ou deux newsletters pertinentes].

Conclusion : par où commencer demain matin ?

Vous avez maintenant une carte complète du territoire du context engineering. Le plus grand risque serait de refermer cette page et de ne rien changer. La transition du prompt engineering à l’ingénierie de contexte n’est pas une option, c’est une nécessité pour quiconque veut construire des agents IA qui fonctionnent réellement en production.

Retenez ces trois points essentiels :

- Le context engineering n’est pas optionnel pour les agents IA en production. C’est la fondation de leur fiabilité.

- 80% des échecs d’agents proviennent du contexte, pas du modèle. C’est là que votre attention doit se porter.

- L’investissement initial (architecture, outils) génère un ROI mesurable en performance, coût et satisfaction utilisateur, souvent en moins de 3 mois.

Alors, par où commencer concrètement ? Voici un plan d’action simple en 3 étapes :

- Cette semaine : Auditez un de vos agents actuels. Quel est son taux d’échec ? Listez les informations qui lui manquent dans son contexte pour réussir.

- Ce mois-ci : Implémentez le pattern RAG + mémoire sur votre agent le plus critique et mesurez l’amélioration du taux de succès.

Sources et références

Cet article s’appuie sur des données et des recherches vérifiées pour garantir sa précision et sa fiabilité.

- Anthropic. (2025). Context Engineering for Business. https://www.anthropic.com/news/context-engineering-for-business

- Karpathy, A. (2024). Tweet sur le context engineering.

- LangChain Team. (2025). The rise of context engineering.

- Stanford University. (2025). Agentic Context Engineering (ACE) Research Paper.

- Anthropic. (2025). Model Context Protocol (MCP) Documentation.

Documentation de référence

[1] ContextEngineering

Super article ! J’adore comment tu transformes la notion technique de « context engineering » en levier concret pour booster l’efficacité : on ne parle plus seulement de “faire beaucoup”, mais de “faire mieux en cadrant ce qui compte”. Le passage sur le fait de sélectionner l’info utile plutôt que de se noyer dans un tsunami de données m’a particulièrement parlé : dans un monde ultra‑connecté, simplifier c’est déjà réussir. Merci pour cette invitation à donner de la clarté à son contexte avant de courir après les tâches !

Article fascinant.

Je savais que le contexte était important par contre je ne connaissais pas le context engineering (et bravo pour la mise en page de cet article).

J’ai une question, est-ce qu’il y a autre chose au dessus du contexte ? Comme le sector engineering ?

Merci guillaume pour le commentaire. Le context engineering vise justement à structurer l’information pour un meilleur traitement. Il faut néanmoins être vigilant à ne pas en donner trop (Overfitting) qui sature la mémoire de l’IA et l’empêche de prendre en compte des éléments important.

Ton article sur le context engineering m’a vraiment parlé. Quand tu écris : « Les échecs d’agent IA ne relèvent pas du modèle : ce sont des échecs de contexte », tu exposes en une ligne ce que beaucoup ratent même après des mois d’usage. Ton ton est clair, sans jargon inutile, et ça donne envie de revoir sa façon de structurer les inputs plutôt que blâmer le modèle. Lecture utile, tu vas à l’essentiel sans posture 😉

J’aime le sujet de l ia et de la productivité .

cet article semble riche mais en tant qu internaute qui se sert de ia pour être productif je le trouve trop expert .

aurais tu du contenu qui simplifie le sujet ?

Merci pour ton retour, c’est vraiment précieux ! Tu as raison : l’IA et la productivité, c’est un sujet passionnant, mais il peut vite devenir technique et intimidant.

Le context engineering (ou « ingénierie de contexte ») est effectivement un concept un peu complexe, car il touche à la façon dont on structure et optimise les informations pour que l’IA comprenne et réponde au mieux. L’article que tu as lu va effectivement assez loin dans les détails.

Voici ce que je peux te proposer :

Je vais ajouter des schémas visuels pour rendre les idées plus claires et concrètes.

Je prépare aussi un guide pratique, étape par étape, avec des exemples concrets et des bonnes pratiques pour bien structurer ses sources et ses requêtes, même sans être expert.

Est-ce qu’il y a un aspect en particulier du context engineering qui t’intéresse ou qui te bloque ? Je peux t’aider à le simplifier !

Merci pour cet article qui montre bien que la qualité de réponse des LLM est conditionnée par la qualité des informations entrantes et par la question. On lit souvent des titres d’actualités du type « Ce que chat GPT prévoit pour… », qui montrent la méconnaissance du fonctionnement du contexte et du prompting. Merci pour cet éclairage un peu technique, mais très riche.

Je suis un peu de l’avis de Christopher ! C’est tellement riche qu’on peut avoir du mal à se projeter sur sa mise en application !

Mais j’adore le travail précis et rigoureux réalisé ! (et documenté) C’est très précieux !

Merci Freddy !