Qu’est-ce que la compression de prompts ?

Imagine un instant que tu aies développé une automatisation géniale basée sur l’IA générative. Tu te félicites, mais soudain, tu te rends compte que les coûts d’exploitation explosent à cause de l’utilisation croissante de ces automatisations !

Pas de panique, il existe une solution pour éviter ce cauchemar : la compression de prompts. Cette technique permet de réduire significativement le nombre de tokens en entrée des modèles de langage, sans pour autant compromettre la qualité des réponses générées.

Dans cet article, nous allons explorer en détail la compression de prompts IA. Tu découvriras son fonctionnement, ses avantages, ainsi que les bonnes pratiques et outils pour la mettre en œuvre efficacement dans tes applications. Prêt à optimiser tes modèles ? C’est parti !

Définitions et concepts clés

Qu’est-ce qu’un token ?

Les tokens sont les unités fondamentales utilisées par les modèles d’intelligence artificielle pour traiter le langage. Ils peuvent représenter des lettres, des syllabes, des mots entiers ou des parties de mots.

Le processus de tokenisation convertit le texte en une série de ces unités, permettant aux modèles d’IA de comprendre, analyser et générer du langage. Les tokens sont essentiels car ils servent d’interface entre le langage humain et le langage machine, facilitant ainsi l’apprentissage des relations sémantiques et syntaxiques.

La facturation des services d’IA est souvent basée sur le nombre de tokens traités, car ils reflètent la quantité de travail effectuée par le modèle. Plus un texte contient de tokens, plus son traitement est coûteux en termes de ressources computationnelles.

Qu’est-ce que la compression de prompts ?

Tu connais la compression de dossier .zip ou de musique en format Flac ? C’est le même principe !

La compression de prompts consiste à réduire systématiquement le nombre de tokens envoyés à un grand modèle de langage (LLM), tout en préservant au maximum la qualité de la sortie par rapport au prompt original non compressé.

L’idée est de fournir des prompts détaillés pour conditionner le modèle à générer des réponses qui respectent certaines spécifications. Bien que les prompts longs donnent généralement de bons résultats, ils ont des inconvénients : nombre de tokens élevé, surcharge de calcul, latence plus importante. C’est là qu’intervient la compression de prompts.

Fonctionnement et techniques de compression

Le principe fondamental est que même si un prompt détaillé donne une réponse satisfaisante, ce n’est pas sa longueur qui compte, mais plutôt les informations clés et le contexte essentiel qu’il contient.

Les techniques de compression permettent de conserver le contenu global du prompt initial tout en réduisant fortement le nombre de tokens. Il peut y avoir une légère perte d’information, surtout pour les éléments mentionnés rarement. Mais globalement, les avantages l’emportent largement.

Avantages : réduction des coûts, efficacité, évolutivité

Réduire le nombre de tokens en entrée des LLM apporte de nombreux bénéfices :

- Réduction des coûts : moins de tokens = moins de calculs = facture moins salée en fin de mois.

- Efficacité accrue : un prompt compressé signifie une latence plus faible et des réponses générées plus rapidement.

- Meilleure évolutivité : ton application pourra monter en charge et gérer un nombre croissant d’utilisateurs sans exploser en vol.

En bref, la compression de prompts est un levier essentiel pour atteindre l’efficience opérationnelle tant recherchée, sans sacrifier l’expérience utilisateur. Le combo gagnant !

Bonnes pratiques de compression de prompts

Si tu as lu mes articles concernant mes astuces pour bien utiliser ChatGPT et les stratégies pour obtenir de meilleurs résultats avec IA. Tu maîtrises les fonctions intéressantes de l’outil et la construction de prompts. La compression est une étape complémentaire.

Supprimer les mots superflus

Premier réflexe pour compresser un prompt : éliminer tous les mots qui n’apportent pas vraiment de valeur. Adjectifs décoratifs, formulations alambiquées, répétitions… Fais place nette !

Exemple :

- Avant : « Peux-tu, s’il te plaît, me donner des informations détaillées et complètes sur l’histoire ancienne de la ville de Paris ? »

- Après : « Donne-moi des informations sur l’histoire ancienne de Paris. »

Cible l’essentiel, sois direct, factuel. Chaque mot doit avoir sa raison d’être. Ton prompt devrait ressembler à un bon résumé, pas à une dissertation.

Restructurer les phrases

Au-delà des mots individuels, pense à reformuler tes phrases. Privilégie des tournures concises et percutantes. Transforme les subordonnées en simples compléments. Remplace les périphrases par le terme exact. L’objectif : exprimer la même idée en un minimum de mots, sans perdre en clarté.

Exemple :

- Avant : « Je voudrais connaître les différentes étapes du processus de fabrication du fromage de chèvre en France, en mettant l’accent sur les méthodes traditionnelles utilisées. »

- Après : « Décris les étapes du processus traditionnel de fabrication du fromage de chèvre en France. »

Préserver le contexte essentiel

Attention à ne pas tomber dans l’excès inverse ! À force de raccourcir, tu risques de perdre des éléments de contexte cruciaux. Ton prompt compressé doit toujours contenir les informations minimales pour que le LLM comprenne la tâche et le domaine. Sinon, tu obtiendras des réponses hors sujet ou incohérentes.

Garde les entités nommées importantes, les mots-clés du domaine, les éléments qui cadrent le raisonnement attendu. Le reste est secondaire.

Exemple :

- Avant : « Veuillez fournir une analyse détaillée des impacts environnementaux potentiels de la construction de nouveaux gratte-ciels dans la région métropolitaine de New York. »

- Après : « Analyse les impacts environnementaux de la construction de gratte-ciels à New York. »

Équilibre entre compression et qualité

Tout est une question d’équilibre. Il faut trouver le juste milieu entre réduction des coûts et préservation de la qualité. Une bonne compression ne devrait pas dénaturer la sortie générée par le modèle. Tu dois donc tester et ajuster tes prompts compressés pour obtenir un bon compromis.

Exemple :

- Avant : « Peux-tu m’expliquer en détail comment fonctionne le système de santé en France, en particulier les différences entre le secteur public et le secteur privé, ainsi que les avantages et les inconvénients de chacun ? »

- Après : « Explique le fonctionnement du système de santé en France, en comparant le secteur public et privé. »

Outils et techniques avancées de compression de prompts

Utilisation d’algorithmes de compression

Présentation

Pour automatiser la compression des prompts, tu peux recourir à des algorithmes spécifiques. Ces outils analysent le prompt original, identifient les parties redondantes ou superflues et proposent une version plus concise.

Certains algorithmes utilisent des techniques de réduction de dimensionnalité, d’autres appliquent des méthodes de résumé automatique. Dans tous les cas, l’objectif est de conserver l’essence du prompt tout en réduisant le nombre de tokens.

Pour vous faciliter la tâche, plusieurs outils et bibliothèques ont été développés ces dernières années. Ils intègrent différentes techniques pour compresser vos prompts de façon quasi-automatique.

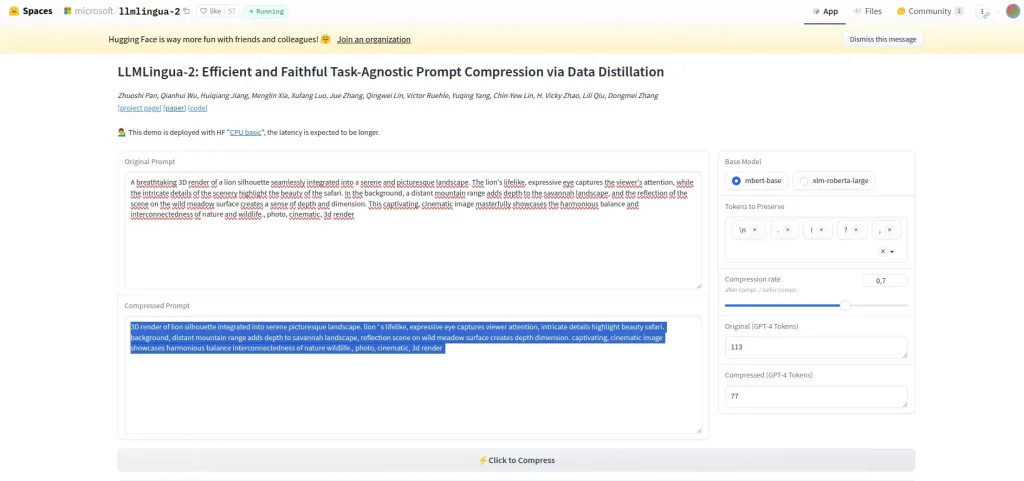

LLMLingua-2

Je vous présente l’outil de compression que j’utilise. LLMLingua-2 est un outil de compression de prompts développés par une équipe de recherche de l’Université Tsinghua et de Microsoft Corporation. Ce modèle utilise un encodeur de transformateur pour analyser le contexte des prompts de manière bidirectionnelle et identifier les informations essentielles à compresser. Grâce à la technique de distillation des données, LLMLingua-2 extrait les informations clés et condense les prompts tout en préservant les détails essentiels

Selon les benchmarks publiés, LLMLingua permet de compresser les prompts jusqu’à 75% de leur taille initiale, tout en préservant plus de 90% des performances sur des tâches complexes de question-réponse, par exemple.

Impressionnant !

L’outil fonctionne mieux et le gain est plus intéressant avec des prompts conséquents.

Il existe un page permettant de tester l’outil via le site Hugginface :

Voici l’image du premier prompt :

« A breathtaking 3D render of a lion silhouette seamlessly integrated into a serene and picturesque landscape. The lion’s lifelike, expressive eye captures the viewer’s attention, while the intricate details of the scenery highlight the beauty of the safari. In the background, a distant mountain range adds depth to the savannah landscape, and the reflection of the scene on the wild meadow surface creates a sense of depth and dimension. This captivating, cinematic image masterfully showcases the harmonious balance and interconnectedness of nature and wildlife., photo, cinematic, 3d render »

Voici l’image pour le prompt compressé à 70%:

« 3D render of lion silhouette integrated into serene picturesque landscape. lion ‘ s lifelike, expressive eye captures viewer attention, intricate details highlight beauty safari. background, distant mountain range adds depth to savannah landscape, reflection scene on wild meadow surface creates depth dimension. captivating, cinematic image showcases harmonious balance interconnectedness of nature wildlife., photo, cinematic, 3d render »

J’ai fait une erreur sur le choix du format 16/9 au lieu de 9/16. Mais le rendu est assez proche. On voit que l’outil enlève les articles et conserve les mots les plus forts.

Fine-tuning des modèles

Une autre approche consiste à fine-tuner ton modèle de langage sur des prompts compressés. En entraînant ton modèle sur des prompts courts mais informatifs, tu peux l’habituer à générer des réponses de qualité même avec moins de tokens en entrée.

Le fine-tuning permet d’ajuster les pondérations internes du modèle pour qu’il accorde plus d’importance aux informations clés et moins aux détails secondaires. Cela peut considérablement améliorer les performances de génération sur des prompts compressés.

Conclusion

La compression de prompts est une technique puissante pour optimiser l’utilisation des modèles de langage. En réduisant le nombre de tokens en entrée, tu peux diminuer les coûts, améliorer l’efficacité et assurer une meilleure évolutivité de ton application.

Pour y parvenir, il est essentiel de supprimer les mots superflus, de restructurer les phrases et de préserver le contexte essentiel. Les outils et les techniques avancées, comme les algorithmes de compression et le fine-tuning, peuvent aussi grandement faciliter cette tâche.

En suivant ces bonnes pratiques, tu pourras tirer le meilleur parti de tes modèles de langage tout en maîtrisant les coûts opérationnels. Est ce que ce type d’optimisation t’intéresse? N’hésite pas à partager en commentaire, ton retour d’expérience.

Si tu es prêt à compresser tes prompts et à optimiser tes applications ? À toi de jouer !

J’ai encore appris plein de choses grâce à ton blog ! Merci !

Je le pratiquais déjà sans le savoir ! Car en plus on gagne un temps fou. Je vois encore trop de gens qui sont trop polis avec les IA et qui perdent du temps à dire « bonjour Claude Sonnet, j’aimerai s’il te plait que tu me fasses… »

Merci Flore pour ton partage. Avec l’expérience on arrive naturel à améliorer ses prompts en se concentrant sur l’essentiel. L’outil permet d’automatiser le traitement.

Ça facilite la vie. Ton article apporte la lumière à certains de mes questionnements. J’adore l’image avec le lion. Merci pour tes conseils.

Très instructif, merci ! Comme toujours que de bons conseils à retenir !

Merci Jessica pour le commentaire

Merci pour ton article. Les exemples concrets et les bonnes pratiques que tu partages sont très utiles pour comprendre comment appliquer cette technique. L’outil LLMLingua-2 semble super pour automatiser la compression tout en préservant la qualité. Hâte de tester ces astuces et de lire tes prochains articles sur l’optimisation des applications IA.

Merci Caroline et Mathieu pour votre commentaire. Oui rien de mieux que de tester pour se rendre compte de l’intérêt de l’outil.

Je ne connaissais pas du tout la compression de prompt et j essaierai de tester tout ça. Merci pr les infos

Merci pour cet article, je connaissais la compression pour les images ou le code mais je ne savais pas que c’est aussi utilisé pour les prompts.

Avant de me mettre à compresser des prompts, il faudrait déjà que je créé des prompts ^^ Merci pour cet article qui me fait entrer un petit peu dans ce monde mystérieux. Bon, j’ai bien évidemment utilisé Chat GPT pour tester. Mais j’avoue ne pas être une grande fan d’IA pour le moment. Mais comme j’aime les bonnes relations, je la salue et la remercie malgré tout quand je lui demande des choses 🤣

Je trouve amusant que l’obtention de bons résultats IA passe par une bonne maîtrise de la langue ! Et tout autant que certaines IA soient là pour pallier les lacunes de leurs propres utilisateurs. Comme quoi pour bien exploiter l’intelligence artificielle, il faut être doté d’une bonne intelligence humaine ! 😉

Merci Denis, oui finalement l’IA reste un booster de compétences. Elle permet de tirer le meilleur de son savoir faire (ou pas).

La compression de prompt, et bien oui ça parait évident et ta comparaison avec les compression de fichier m’a tout de suite parlé.

Ça parait évident, mais je n’y avais même pas pensé.

Pas facile pour moi d’enlever les formules de politesse, les articles, etc pour demander à mon assistante de travailler.

Pour y arriver il va falloir que je repense « prompt programmation » bien plus que IA.

Tu me fais progresser, encore une fois.

Merci pour cet article extrêmement instructif et qui sera très aidant dans l’utilisation des IA.

Merci Freddy pour tous ces éléments.

C’est une analyse personnelle, mais l’IA a 3 principaux inconvénients en dépit de ces multiples avantages :

le coût comme il est rappelé dans l’article

les hallucinations

le problème juridique du droit d’auteur.

L’IA permet d’affiner des analyses sur les données financières et météorologiques, ce sont des exemples de modèles plus fiables, mais aussi de coûts. Ce paramètre est bien sûr essentiel dans la recherche des modèles.

Merci pour cet article ! J’ai souri en lisant ton passage sur « Peux-tu s’il te plaît… ». J’ai tendance à être aussi polie avec chatGPT qu’avec un humain. Je pensais que ça n’avait pas d’impact en terme de résultats ou d’efficacité. Maintenant, je vais essayer d’être plus directe ! Et si c’est trop difficile, j’essaierai de revoir mes prompts avec les logiciels que tu mentionnes.